08. 05. 2025

Verfasst von: Daniel Giffhorn, Reinhard Gerndt

Kampf mit KI – vom Spiel zum Ernst

Die Friedens- und Konfliktforschung ist in Europa aktueller denn je. Dazu zählt auch das Bewusstsein, dass der zunehmende KI-Einsatz nicht vor autonomen Waffen- und Verteidigungssystemen Halt macht. Die Ostfalia Hochschule untersucht in einem Verbundprojekt, ob und wie in der Auseinandersetzung zwischen autonomen Robotern eine sinnvolle menschliche Kontrolle möglich ist. Für die Interaktionen unter Regeln, Sanktionen und ethischen Aspekten nutzt das Forschungsteam Roboter-Fußballer als Testszenario.

Kontrolle über Regeln, Sanktionen und Ethik

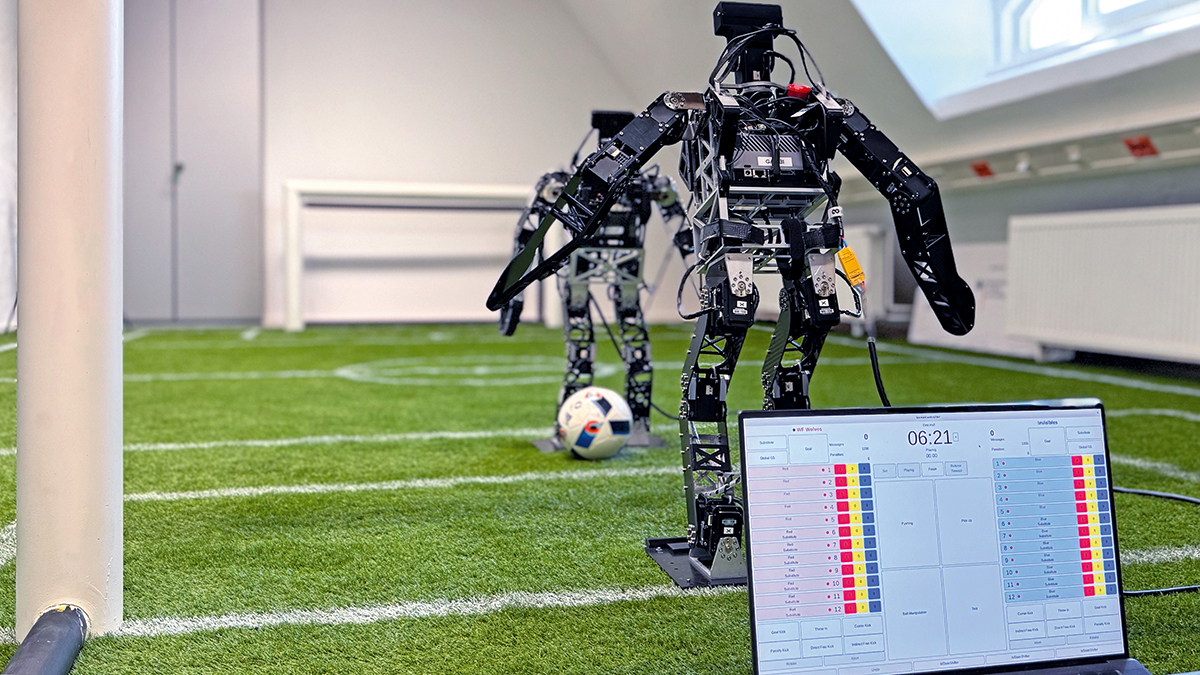

Fußball ist für die meisten Menschen ein sportlicher Wettstreit, der auf klaren Regeln basiert. Und dennoch dienen Regelverstöße, unfaires Spiel und darauffolgende – oder ausbleibende – Sanktionen oftmals als Ventil für Streit und weitere Aggressionen. In diesem Sinne nutzen Forscherinnen und Forscher der Ostfalia Hochschule das Fußballspiel von humanoiden Robotern (RoboCup) als Testszenario, um sich weitaus ernsteren Konflikten zu nähern. Im MeHuCo-Projekt (Meaningful Human Control) werfen sie einen kritischen Blick auf den Einsatz von KI speziell in autonomen Waffensystemen. Die Forschenden untersuchen dabei die Möglichkeiten, Ethik in den Wettkampf zu implementieren und Schiedsrichterentscheidungen zu automatisieren – ähnlich einer globalen Kontrolle für autonome Systeme.

Regelverletzungen erkennen und sanktionieren

„Fußball ist einem militärischen Konflikt sehr ähnlich“, abstrahiert Projektmitarbeiter Daniel Giffhorn die RoboCup-Ebene. „In zukünftigen Konflikten treten sehr wahrscheinlich auch zwei autonome Roboterteams gegeneinander an, um diesen auszutragen.“ Ziel der Simulationen und Experimente mit den Robo-Fußballern ist es, Regelverletzungen durch die Roboter frühzeitig zu erkennen und durch menschliche Intervention abzustellen oder zu sanktionieren. Das Projektteam konzentriert sich darauf, Schwächen von KI aufzuzeigen und zu eliminieren, beispielsweise die Unerklärbarkeit von KI-Modellen, die fehlende Vorhersehbarkeit oder die Unzuverlässigkeit je nach benutzten Trainingsdaten. Die Implementierung von Ethik bedeutet das Einhalten bestimmter Regeln, etwa dass verletzte Roboter weggehen.

Grenzen einer menschlichen Kontrolle ausloten

Das Team vergleicht eine KI mit einem neugeborenen Kind, welches Situationen und Handlungsmöglichkeiten erst erlernen muss. „Anders als bei Kindern kann sich das Fehlverhalten von KI-Systemen aber deutlich gravierender auf die Umwelt oder auf Teilsysteme auswirken“, erläutert Prof. Dr.-Ing. Reinhard Gerndt. Bei einer fehlerhaften Objekterkennung beim RoboCup könnte ein Roboter einen Menschen treten und verletzen. Im Kriegsfall sind die Folgen weitaus schlimmer, wenn eine autonome Drohne eine Rakete auf die eigenen Truppen oder auf Zivilisten abfeuert. Die Projektergebnisse sollen die Grenzen einer sinnvollen Kontrolle ausloten. Dabei sehen die Forschenden auch die Gefahr, dass ein steigendes Vertrauen in die Nutzung solcher Systeme zu einem unreflektierten Einsatz führen könnte. Das Projekt der Friedens- und Konfliktforschung wird von einem Konsortium aus vier Universitäten und der Ostfalia Hochschule bearbeitet und vom Bundesforschungsministerium gefördert.

Hier finden Sie weitere Informationen:

- Meaningful Human Control – Autonome Waffensysteme zwischen Regulation und Reflexion

Fakultät Informatik, Human-Centered Robotics Lab

Fakultät Informatik, Human-Centered Robotics Lab

Fakultät Informatik, Human-Centered Robotics Lab

Fakultät Informatik, Human-Centered Robotics Lab

38302 Wolfenbüttel

38302 Wolfenbüttel