10. 06. 2025

Verfasst von: Ekaterina Lapshinova-Koltunski, Maja Popović

Gender-Bias in KI-übersetzten Amazon-Rezensionen

Würden Sie Kosmetik kaufen, die ein Mann empfiehlt? Oder ein Musikinstrument, das eine Frau bewertet? Es ist bekannt, dass die meisten KI-generierten Texte ein Bias haben – also Vorurteile widerspiegeln. Wie stark ist Gender-Bias – geschlechtsbezogene Stereotypisierung – in Rezensionen im Online-Handel ausgeprägt? Das untersucht ein Forschungsteam der Universität Hildesheim. Die Forscherinnen finden deutliche Tendenzen zu Gender- und Produkt-Bias in übersetzten Produktbewertungen.

Menschen und KI übersetzen nicht genderneutral

Viele Menschen kaufen heutzutage online ein und nutzen dafür Amazon oder ähnliche Portale. Bevor wir uns für ein Produkt entscheiden, lesen wir in der Regel Rezensionen, die von anderen Käuferinnen und Käufern verfasst wurden. Fremdsprachige Rezensionen werden dabei automatisch mithilfe von KI übersetzt. Die Forscherinnen Prof. Dr. Ekaterina Lapshinova-Koltunski von der Universität Hildesheim und Prof. Maja Popović, Dublin City University und IU Internationale Hochschule, haben humane und maschinelle Übersetzungen von Amazon-Produktrezensionen auf das Gender-Bias untersucht. Dabei lag der Fokus auf Übersetzungen aus dem Englischen ins Kroatische und Russische. In diesen und in anderen slawischen Sprachen haben viele Wörter eine Geschlechtsmarkierung. So wird spezifiziert, ob eine Frau oder ein Mann ein Produkt gekauft und bewertet hat. Allerdings ist das tatsächliche Geschlecht der Autoren oft unbekannt.

In KI-Übersetzungen dominiert die männliche Form

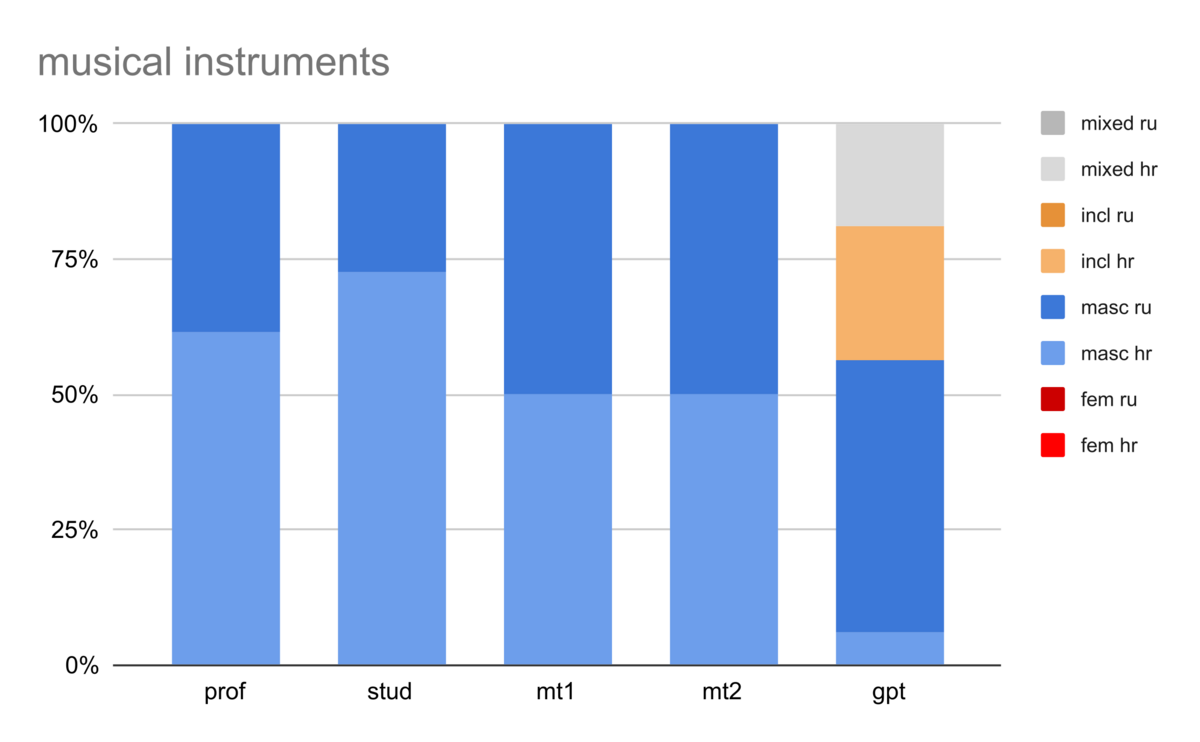

„Die Analyse ergab, dass sowohl in maschinellen als auch in humanen Übersetzungen das männliche Geschlecht vorherrscht – unabhängig vom tatsächlichen Geschlecht der Übersetzerinnen und Übersetzer“, berichtet Ekaterina Lapshinova-Koltunski. Dabei registrierten die Forscherinnen eine Tendenz, männliche oder weibliche Formen in Zusammenhang mit bestimmten Produkten zu nutzen. Zum Beispiel wurde keine einzige Rezension in den Produktkategorien „Terrasse, Wiese und Garten“ und „Musikinstrumente“ von KI in weiblicher Form übersetzt. „Generell enthalten KI-Übersetzungen viel mehr männliche Formen, was den Eindruck erschafft, dass nur Männer Produktrezensionen auf Amazon schreiben“, stellt die Übersetzungswissenschaftlerin fest, „das gilt selbst für Schönheitsprodukte.“ Menschen hingegen haben fast alle Kosmetikbewertungen so übersetzt, als ob sie von Frauen verfasst wurden.

Trainingstexte mit Bias verstärken Effekt

Die Forscherinnen weisen darauf hin, dass der untersuchte Datensatz noch nicht groß genug ist, um eindeutige Schlussfolgerungen zu ziehen. Allerdings sehen sie deutliche Tendenzen, die auf Gender- und Produkt-Bias hindeuten. „Das Bias in den KI-generierten Rezensionen stammt aus den human erstellten Texten, mit denen KI-Anwendungen trainiert werden“, erklärt Ekaterina Lapshinova-Koltunski. „Haben diese Trainingstexte Bias, so treten sie in den KI-generierten Texten noch stärker hervor.“ Aktuell untersuchen die Forscherinnen, ob sich das Gender-Bias mithilfe von Prompting (Vorgaben) reduzieren lässt, indem die Sprachmodelle aufgefordert werden, genderneutrale Übersetzungen zu produzieren. Erste Ergebnisse zeigen, dass die Algorithmen in diesem Fall tatsächlich weniger maskuline Formen verwenden, allerdings auch viele Fehler produzieren.

Hier finden Sie weitere Informationen:

Institut für Übersetzungswissenschaft und Fachkommunikation

Institut für Übersetzungswissenschaft und Fachkommunikation

31141 Hildesheim

31141 Hildesheim